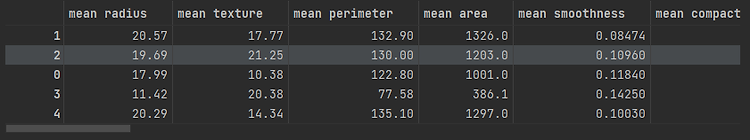

오늘날 대부분의 머신러닝 애플리케이션이 지도학습 기반이지만, 사용할 수 있는 데이터는 대부분 레이블이 존재하지 않습니다. 이러한 레이블이 없는 데이터에 숨겨진 패턴을 찾아내고 구조화하는 머신러닝 기법을 비지도학습(Unsupervised Learning)이라고 하는데, 비지도학습 알고리즘 중 가장 널리알려진 K-Means Clustering 알고리즘에 대해서 알아보겠습니다. 군집은 다음과 같은 다양한 애플리케이션에서 사용됩니다. 고객분류 데이터분석 차원 축소 기법 이상치 탐색 준지도 학습 검색 엔진 이미지 분할 등.. K-Means Clustering "K"는 주어진 데이터로부터 그룹화 할 그룹의 개수, 즉 클러스터의 개수 "Means"는 각 클러스터의 중심과 데이터들의 평균거리를 의미 센트로이드(cent..